Werbung

Wenn Sie die geistigen Fähigkeiten, ein Gespür für Programmierung und Geschichtenerzählen und ein Auge für Design haben, können Sie es schlechter machen, als in die Datenwissenschaft einzusteigen. Es ist das neue große Ding in der Technologie. Hochmodisch und hochbezahlt. Datenwissenschaftler werden von einigen der größten Unternehmen der Welt gesucht.

ScraperWiki ist ein Unternehmen, das seit langem mit dem Bereich Data Science verbunden ist. In den letzten Jahren bietet dieses in Liverpool ansässige Startup Programmierern eine Plattform, um Tools zu schreiben, mit denen Daten abgerufen, bereinigt und in der Cloud analysiert werden können.

Angesichts der jüngsten Aktualisierung und der ständig steigenden Nachfrage nach Datenwissenschaftlern im Unternehmen lohnt es sich, sich ScraperWiki genauer anzusehen.

Vollständige Offenlegung: Ich war letzten Sommer Praktikant bei ScraperWiki.

Was macht ScraperWiki?

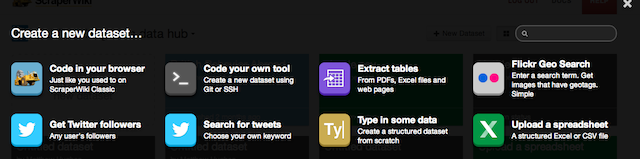

ScraperWiki vermarktet sich als Ort zum Abrufen, Bereinigen und Analysieren von Daten und liefert in jeder dieser Punkte. In seiner einfachsten Form ermöglicht es Ihnen - dem Benutzer - einen Ort, an dem Sie Code schreiben können, der Daten aus einer Quelle abruft, Werkzeuge, die konvertiert werden können es in ein Format, das einfach zu analysieren ist, und Speicher, um es für eine spätere Visualisierung aufzubewahren - was Sie auch mit ScraperWiki verarbeiten können.

Es kommt auch mit einer Reihe von vorgefertigten Tools, die sich wiederholende Aufgaben automatisieren, einschließlich Daten aus PDFs abrufen, die notorisch schwer zu entschlüsseln sind. Dies ist zusätzlich zu Twitter-Suche 5 coole Twitter-Suchtricks, um zu überwachen, was die Leute über Sie sagenWenn Sie eine Website besitzen oder nur versuchen, als Freiberufler online Geld zu verdienen, ist es immer gut zu wissen, was die Leute über das Internet über Sie sagen. Leute zitieren vielleicht ... Weiterlesen und Scraping-Dienstprogramme. Sie benötigen keine Erfahrung in der Softwareentwicklung, um diese zu verwenden.

Kosten

Wie bereits erwähnt, nutzt ScraperWiki das Freemium-Preismodell und bietet einen Service mit mehreren Ebenen. Wer gerade mit Data Science anfängt oder nur begrenzte Bedürfnisse hat, kann den kostenlosen Service nutzen. Dadurch erhalten Sie drei Datensätze, in denen Sie Ihre Daten und Ihren Code speichern.

Wer mehrere Scraper schreiben möchte oder Berge von Datenanalysen durchführen möchte, kann etwas Geld für ein Premium-Konto ausgeben. Diese beginnen bei 9 USD pro Monat und bieten 10 Datensätze. Wenn dies immer noch nicht ausreicht, können Sie jederzeit ein Upgrade auf die höchste Stufe durchführen, die 100 Datensätze enthält und 29 US-Dollar pro Monat kostet.

Codierung

Programmierer sind oft sehr speziell, wenn es darum geht, wie sie codieren. Einige bevorzugen Skriptsprachen gegenüber kompilierten Sprachen. Einige bevorzugen die reduzierte Erfahrung eines Texteditors gegenüber einer integrierten Entwicklungsumgebung (IDE). ScraperWiki erkennt dies und bietet dem Benutzer eine große Auswahl, wenn es darum geht, wie Sie Ihren Code schreiben.

Wenn Sie dazu neigen, können Sie Ihren Code im Browser schreiben. Wie Sie es von jeder professionellen Klasse erwarten würden, webbasiert Die drei wichtigsten browserbasierten IDEs zum Codieren in der Cloud Weiterlesen Entwicklungs-Tool, das Funktionen enthält, die jeder Programmierer als wesentlich erachten würde, wie z. B. das Hervorheben der Syntax.

Es gibt eine Reihe von Sprachen im Angebot. Diese schließen ein Python Die 5 besten Websites zum Erlernen der Python-ProgrammierungMöchten Sie Python-Programmierung lernen? Hier sind die besten Möglichkeiten, Python online zu lernen, von denen viele völlig kostenlos sind. Weiterlesen , eine beliebte Skriptsprache, die von Google und der NASA verwendet wird; Rubin 3 Interaktive, unterhaltsame und kostenlose Möglichkeiten zum Erlernen der Ruby-ProgrammierspracheRuby ist eine ausdrucksstarke Skriptsprache auf sehr hohem Niveau. Es wird im Web hauptsächlich als Teil des Ruby on Rails-Webentwicklungsframeworks verwendet, ist aber auch eigenständig. Wenn Sie neugierig sind, was Ruby (nicht ... Weiterlesen , die eine Reihe von beliebten Websites wie Living Social betreibt; und die beliebte statistische Analysesprache R.

Darüber hinaus können Sie auch Code über die Befehlszeile schreiben, indem Sie SSH, Git und einen beliebigen Texteditor verwenden, den Sie gerne verwenden. Ja, das hast du richtig gelesen. SSH Was SSH ist und wie es sich von FTP unterscheidet [Technologie erklärt] Weiterlesen . Jede Box, die Sie verwenden, ist ein eigenes Linux-Konto, und Sie können eine Verbindung wie bei einem VPS oder einem anderen Shell-Konto herstellen. Es gibt eine Reihe von Texteditoren, darunter Vim Die 7 wichtigsten Gründe, dem Vim-Texteditor eine Chance zu gebenIch habe jahrelang einen Texteditor nach dem anderen ausprobiert. Sie nennen es, ich habe es versucht. Ich habe jeden dieser Editoren über zwei Monate lang als meinen primären täglichen Editor verwendet. Irgendwie ... Weiterlesen Dies kann mit Plugins und durch Bearbeiten der Konfiguration erweitert werden. Diejenigen, die von Vim eingeschüchtert sind, können Nano verwenden, einen leichtgewichtigen Befehlszeilentexteditor.

Die installierten Bibliotheken sollten ausreichen, um Tools zum Abrufen und Verarbeiten von Daten zu schreiben. Wenn Sie etwas Dunkleres benötigen, können Sie jederzeit eine virtuelle Umgebung über die Befehlszeile erstellen. Wie Sie sehen, bieten Entwicklern eine enorme Flexibilität.

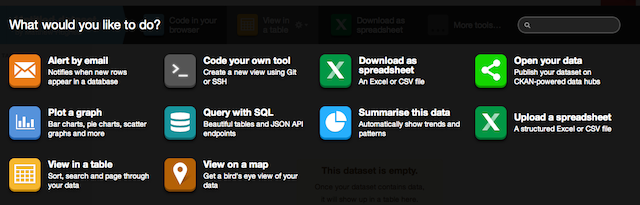

Datenvisualisierung

Sie haben also Ihre Daten. Sie haben es normalisiert. Du hast es gereinigt. Sie haben es analysiert. Jetzt ist es Zeit, etwas zu visualisieren und der Welt zu zeigen, was Sie gelernt haben.

Mit ScraperWiki können Entwickler ihre Daten mithilfe von Webseiten anzeigen, die aus den bekannten Trifecta von HTML, CSS und JavaScript erstellt wurden. Darüber hinaus werden Bootstrap-Komponenten sofort unterstützt.

Es stehen eine Reihe vorgefertigter Visualisierungen zur Verfügung, darunter solche, die Ihre Daten auf einer Karte darstellen und Trends in Ihren Ergebnissen finden. Um diese zu verwenden, müssen Sie sicherstellen, dass Ihre Daten als SQLite-Datei mit dem Dateinamen "scraperwiki.sqlite" gespeichert sind. Anschließend fügen Sie einfach die Visualisierung hinzu, an der Sie interessiert sind. Einfach, richtig?

Fazit

ScraperWiki bietet Entwicklern viel, die Datenanalysen durchführen möchten, ohne dass ihre Entwicklungsumgebung im Weg steht, und gleichzeitig die Flexibilität haben, selbst die anspruchsvollsten Benutzer zufrieden zu stellen. Aber was denkst du? Lass es mich in den Kommentaren unten wissen.

Fotokredit: Raketenwissenschaft (Dan Brown)

Matthew Hughes ist ein Softwareentwickler und Autor aus Liverpool, England. Er wird selten ohne eine Tasse starken schwarzen Kaffee in der Hand gefunden und liebt sein Macbook Pro und seine Kamera. Sie können seinen Blog unter lesen http://www.matthewhughes.co.uk und folge ihm auf Twitter unter @matthewhughes.